Presidente do STF participou de um painel sobre inteligência artificial na Universidade de Oxford

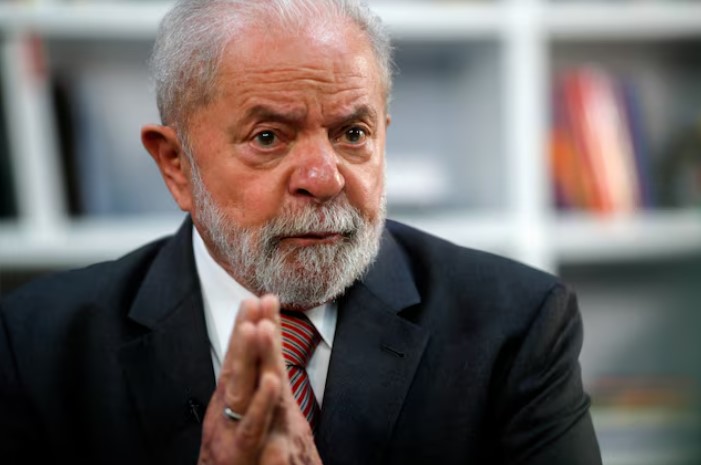

O presidente do Supremo Tribunal de Justiça (STF), Luís Roberto Barroso, afirmou que a massificação da desinformação é uma das maiores preocupações dele quando se trata de inteligência artificial. Fala aconteceu durante um painel que discutia o assunto na Universidade de Oxford, no Reino Unido, neste domingo (23).

Como exemplo, o ministro citou a divulgação de informação incorreta sobre tratamentos alternativos para Covid-19 que podem ser amplamente distribuídos. Segundo ele, se uma quantidade grande de pessoas acreditar no que foi divulgado, se torna um problema de saúde pública.

Questionado sobre os riscos da inteligência artificial, Barroso citou o impacto no mercado de trabalho, utilização para fins bélicos, violação de privacidade, risco de discriminação algorítmica e problemas de direitos autorais. Ele pontuou, ainda, o uso de deep fakes. “Nós somos ensinados a acreditar naquilo que vemos e ouvimos. O dia que nós não pudermos acreditar no que vemos e ouvimos, a liberdade de expressão terá perdido o sentido”, ressalta.

Dentro da Justiça, o ministro acredita que a IA pode ser utilizada “amplamente e para muitas finalidades”, mas que uma regulação própria é necessária, o que é dificultado pela velocidade de desenvolvimento. “Vejo a inteligência artificial como uma linha auxiliar, e não autônoma. Porém, eu acho que pode trazer proveitos em termos de celeridade, eficiência e isonomia, de tratar todos igualmente sem influências indesejáveis”, afirma.

Sobre as áreas que mais necessitam de regulação, Barroso elencou direitos fundamentais, proteção da democracia e governança.

O ministro diz que desinformações que são “objetivamente falsas” devem ser retiradas das redes sociais pelas plataformas imediatamente. Ele exemplifica uma condenação por pedofilia, que pode ser comprovada ou desmentida com facilidade.

Como “regra geral”, Barroso afirma que conteúdos precisam ser removidos depois de decisões judiciais. “Se for evidentemente crime, o algoritmo tem que ser capaz de remover de ofício. E se for uma evidente violação de direito fundamental, você tem que remover depois da notificação privada”, explica.

O presidente comentou que o modelo de negócios das plataformas depende do engajamento das pessoas com os conteúdos, e que “há um certo incentivo perverso a disseminar o que não é bom”.

“Se o incentivo natural é negativo, é preciso ter um contra incentivo para que as pessoas não façam isso”, explica.